Pilotprojekt zur Prognose des Abstimmungsverhaltens in der VN-Generalversammlung

Technischer Annex zur Studie Stanzel/Voelsen, »Diplomatie und Künstliche Intelligenz. Überlegungen zur praktischen Hilfestellung für diplomatische Verhandlungen, SWP-Studie 2021/S 18, 21.10.2021, 33 Seiten

Datensatz: „United Nations General Assembly Resolutions: Voting Data and Issue Categories“

Im September 2021 hat die SWP einen neuen Datensatz zum Abstimmungsverhalten in der Generalversammlung der Vereinten Nationen (United Nations General Assembly, UNGA) veröffentlicht. Der Datensatz bereitet die diesbezüglichen Informationen aus der „Digital Library“ der Vereinten Nationen tabellarisch auf. Beginnend mit Sitzung 49 (1995/96) werden Variablen wie einzelne Abstimmungspositionen, aber auch allgemeine Informationen über die Resolutionen dargestellt. Aktuell enthält der Datensatz Resolutionen bis zum 8. August 2021, d. h. Sitzung 75 (2020/21). Die von der UNGA vergebenen inhaltlichen Schlagwörter wurden genutzt, um über die bisherige politikwissenschaftliche Zuordnung von Resolutionen zu Themenfeldern hinaus eine genauere thematische Zuordnung zu ermöglichen.

Der Datensatz sowie das detaillierte Codebuch sind über GESIS abrufbar: https://doi.org/10.7802/2297

Das Vorgehen im Pilotprojekt

Um das Potenzial von KI für die Zwecke der Vorbereitung und Durchführung diplomatischer Verhandlungen besser einschätzen zu können, haben wir für die Studie in Zusammenarbeit mit dem deutschen Auswärtigen Amt ein Pilotprojekt zur konkreten Nutzung von machine learning (ML) zwecks Auswertung von Daten über Abstimmungen in der UNGA durchgeführt. Die Datenanalyse wurde seitens der SWP durch Paul Bochtler und Rebecca Majewski unterstützt.

Fragestellung

In der Anfangsphase des Pilotprojektes haben wir die Fragestellung wie folgt zugespitzt: Wird ein Staat bei einer wiederkehrenden Resolution im Themenfeld Menschenrechte seine Position verändern?

Datengrundlage

Die Datengrundlage hierfür war der von der SWP neu erstellte Datensatz zum Abstimmungsverhalten in der UNGA (s. o.). Daraus haben wir eine Teilmenge von Resolutionen ausgewählt: wiederkehrende kontroverse Resolutionen im Themenfeld Menschenrechte.

Kontrovers heißt in diesem Fall, dass in der Vergangenheit mindestens eine Resolution aus einer Gruppe wiederkehrender Resolutionen mit weniger als 70 % Ja-Stimmen angenommen wurde (613 Resolutionen aus 65 Gruppen wiederkehrender Resolutionen). Die Abstimmungsdaten für diese Teilmenge haben wir mit weiteren Informationen zu den Staaten kombiniert (z. B. Regime-Typ, Mitgliedschaft in internationalen und regionalen Organisationen).

Für den in der Studie ausführlicher in den Blick genommenen Fall der Cybercrime-Resolution haben wir aus unserem Datensatz eine Teilmenge aller wiederkehrenden Resolutionen aus dem Themenfeld „127 – Internet, Computer Security, Telecommunications, Cybersecurity, Cybercrime“ gebildet.

Modellspezifizierung

Auf der Grundlage der so ausgesuchten Trainingsdaten (Session 51–72) haben wir mithilfe eines Random forest-Algorithmus prognostiziert, welche Staaten in den folgenden Sitzungen 73 und 74 hinsichtlich der wiederkehrenden Resolutionen wahrscheinlich ihr Abstimmungsverhalten ändern werden. Da uns die realen Abstimmungsergebnisse aus diesen zwei Sitzungen vorlagen, konnten wir die Genauigkeit der Prognose an dem tatsächlichen Abstimmungsverhalten messen.

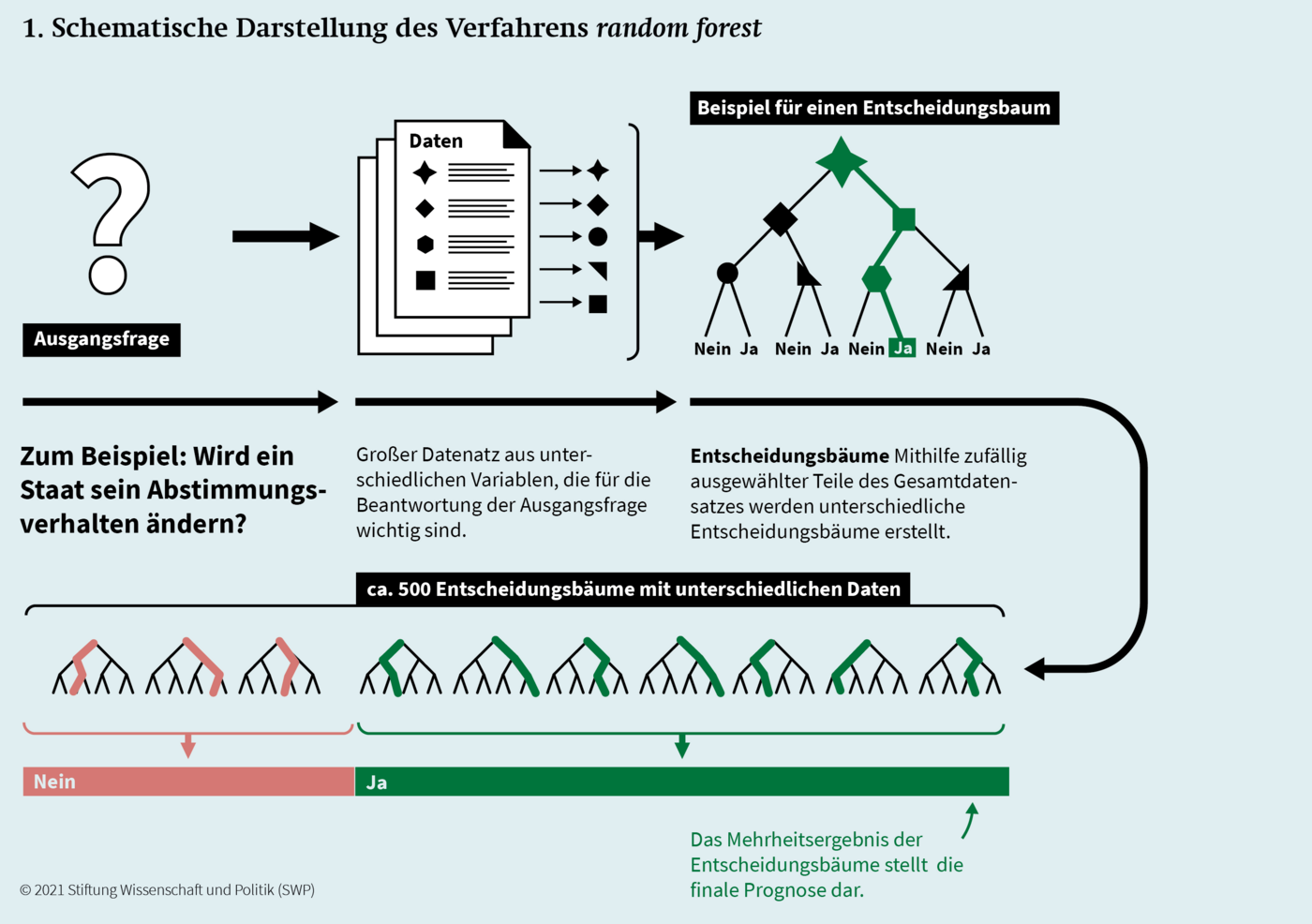

In Abbildung 1 ist das Prinzip des Algorithmus abgebildet. Im ersten Schritt wird aus dem Datensatz eine zufällige Auswahl an Variablen herausgezogen, mit deren Hilfe, basierend auf den Trainingsdaten, ein Entscheidungsbaum gebildet wird. Dabei versucht der Algorithmus, auf Grundlage der ihm zur Verfügung stehenden Variablen möglichst effiziente Entscheidungsbäume zu bilden, die mit einer minimalen Anzahl an Variablen die größtmögliche Anzahl an Veränderungen korrekt vorhersagen. Dieses Prozedere wird mit einer variierenden Anzahl zufällig ausgewählter Teile des Datensatzes wiederholt (bis zu 500). In diesem Fall belief sich die optimale Anzahl an Wiederholungen auf 187. Anschließend wird die finale Prognose aus einer „Mehrheitsabstimmung“ der aus den Trainingsdaten entstandenen Bäume getroffen, d. h., die Entscheidungsbäume aus Session 51 bis 72 werden auf Session 73 angewandt. Jeder der 187 Entscheidungsbäume erhält eine „Stimme“ und das häufigste Ergebnis stellt das Ergebnis der Prognose dar.

1. Schematische Darstellung des Verfahrens random forest

Zusätzlich haben wir im Training sogenannte Hyperparameter über eine maximale Entropiematrix anhand eines extending horizon (time series split in der cross validation mit zwölf folds) mit zunehmender Anzahl an Trainingsdaten nachjustiert. Dabei wurden folgende Hyperparameter variiert:

- die Anzahl zufällig ausgewählter Variablen (mtry) für decision trees (dt),

- die Anzahl der zu berechnenden dt (trees) sowie

- die Anzahl der minimal vorhandenen Sample-Größe je split (min_n).

Die Optimierung wurde mithilfe des resultierenden F1-Scores durchgeführt. Da die Daten imbalanced waren (meistens gab es keine Veränderung im Abstimmungsverhalten), haben wir downsampling eingesetzt, bei dem randomisiert Beobachtungen aus der Mehrheitskategorie ausgeschlossen werden. Für die Analyse haben wir das R-Package tidymodels von Max Kuhn und Hadley Wickham genutzt.

Wir haben im Prozess verschiedene Modellspezifikationen ausgewählt, die sich in den folgenden Aspekten unterscheiden:

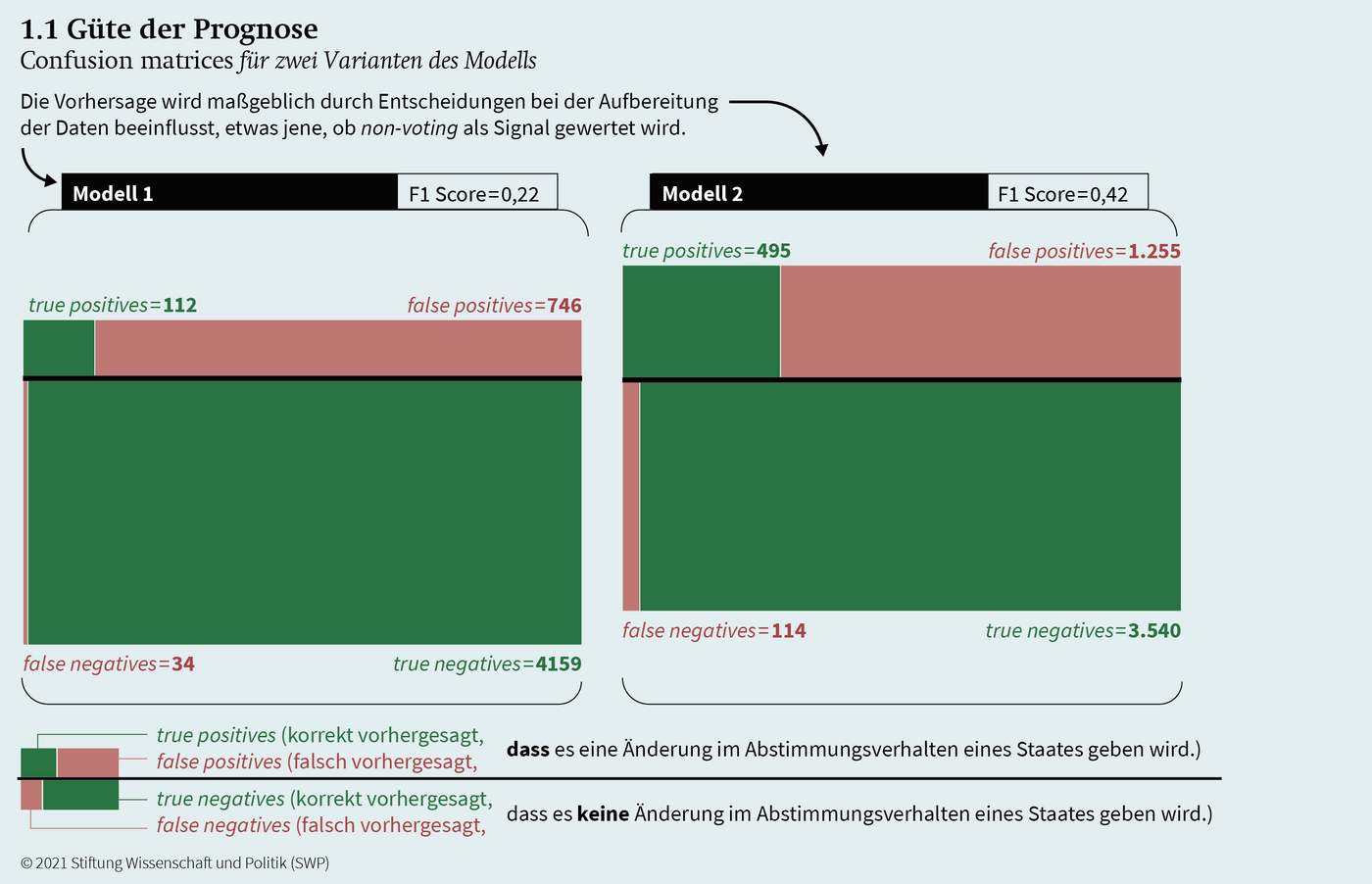

In der politischen Praxis sind die voraussichtlichen Positionen der fünf ständigen Mitglieder des VN-Sicherheitsrates (P5) meistens im Voraus bekannt. Deswegen wurden bei einigen Modellen die Positionen der P5 (und entsprechend ggf. deren Veränderungen) für die zu prognostizierenden Resolutionen bewusst mit berücksichtigt. Die These dahinter lautet, dass dies ein relevanter Datenpunkt für die Prognose des Verhaltens von anderen Staaten sein könnte. Diese Konfiguration wurde sowohl für Modell 1 als auch für Modell 2 in Abbildung 1.1 gewählt.

In den VN gibt es vier Abstimmungspositionen: „Ja“, „Nein“, Enthaltung und Nicht-Teilnahme (non-voting). In einigen Modellen haben wir eine Veränderung des Abstimmungsverhaltens registriert, wenn ein Staat an einer Abstimmung nicht teilgenommen hat, bei anderen Modellen haben wir dieses Verhalten ausgeschlossen.

Als Beispiel:

-

Resolution A, Staat X, Session 70 = Ja

-

Resolution A, Staat X, Session 71 = non-voting

-

Resolution A, Staat X, Session 72 = Ja

In Modell 2 (s. Abbildung 1.1) sind hier zwei Änderungen registriert: Von „Ja“ zu non-voting und von non-voting zu „Ja“. In Modell 1 (s. Abbildung 1.1) ist hier keine Änderung enthalten, da die Position non-voting in Session 71 ausgeschlossen wird und von „Ja“ zu „Ja“ keine Änderung besteht.

Im Laufe des Projektes sind wir zu dem Ergebnis gekommen, dass für die diplomatische Praxis die sensitivity, d. h. die Rate der erkannten Veränderungen am wichtigsten ist. Dementsprechend haben wir in einer weiteren Modellspezifikation den threshold – also den Grad der Wahrscheinlichkeit, ab dem eine prognostizierte Veränderung tatsächlich als Veränderung gewertet wird (z. B. Wahrscheinlichkeit der Veränderung mindestens 60 %) – anhand der sensitivity maximiert (zwischen 0 und 1). Hierfür haben wir den Wert ausgesucht, mit dem mindestens 80 % der Veränderungen erfasst und die wenigsten Abstimmungsergebnisse falsch prognostiziert wurden. Streng genommen wurde demnach nicht nur nach sensitivity maximiert, sondern der beste F1-Score mit einer sensitivity von mindestens 80 % ausgewählt. Diese Methode wurde bei Modell 1 und 2 (Abbildung 1.1) angewandt.

Ergebnis und Güte der Prognose

Das Ergebnis dieses Pilotprojektes lautet, dass eine solche Prognose grundsätzlich möglich ist, die Güte der Prognose allerdings bisher noch nicht gänzlich zufriedenstellt: Erfasst man einen Großteil der Veränderungen im Staatenverhalten, zahlt man dafür mit teils sehr vielen false positives. Auch scheint das Modell für unterschiedliche Staaten unterschiedlich gut zu funktionieren, wobei hier bis jetzt noch keine klare Systematik zu erkennen ist. Durch weitere Arbeit an dem Modell und ggf. Hinzufügen weiterer Daten scheint es uns aber möglich, die Prognose weiter zu verbessern. In jedem Fall ist es ratsam, ein solches System so zu gestalten, dass das Erfahrungswissen aus der Praxis der Diplomaten integriert werden kann.

Die folgenden Abbildungen fassen unsere Ergebnisse bzgl. der Güte der Prognose zusammen:

1.1 Güte der Prognose, Confusion matrices für zwei Varianten des Models

In Abbildung 1.1 ist zu erkennen, dass die Modellspezifikation die Ergebnisse erheblich verändert. Die Inklusion von non-voting als Signal (Modell 2) wirkt sich auf die Anzahl der absoluten Veränderungen aus und verschiebt außerdem das Verhältnis von true positives zu false positives zugunsten einer besseren Prognose. Inhaltlich ist aber fraglich, ob non-voting ein valides Signal ist.

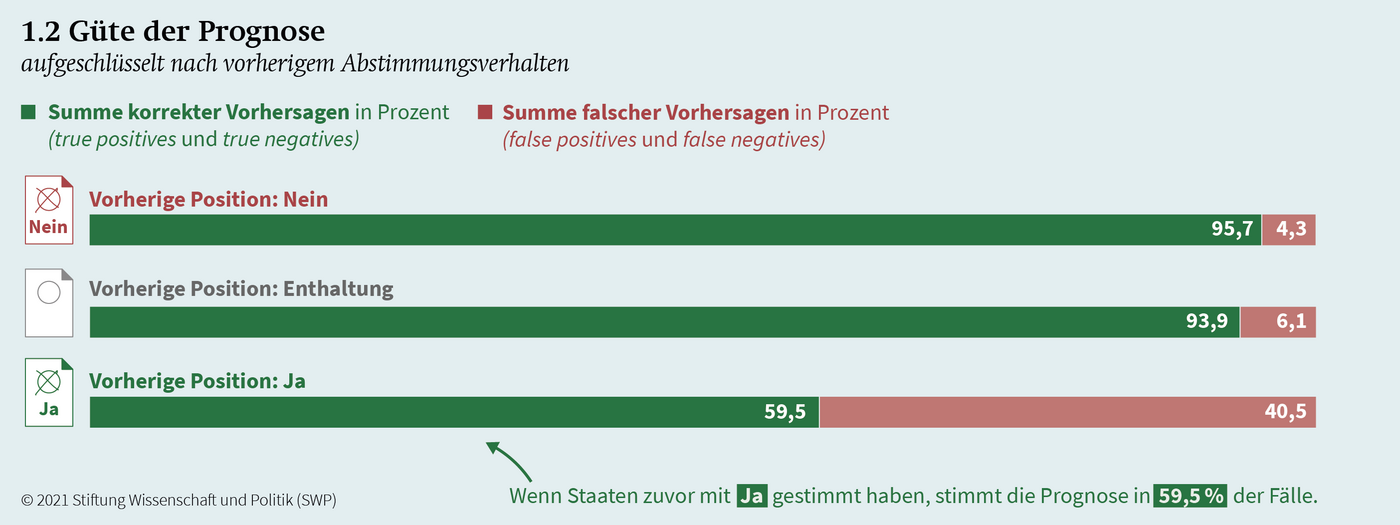

1.2 Güte der Prognose, aufgeschlüsselt nach vorherigem Abstimmungsverhalten

In Abbildung 1.2 ist zu erkennen, dass die Güte der Prognose je nach vorheriger Abstimmungsposition variiert. Das drückt sich besonders darin aus, dass die Prognose dort, wo das richtige Abstimmungsverhalten nach einem „Ja“ vorhergesagt werden soll, nur in etwa 60 % der Fälle richtig liegt.

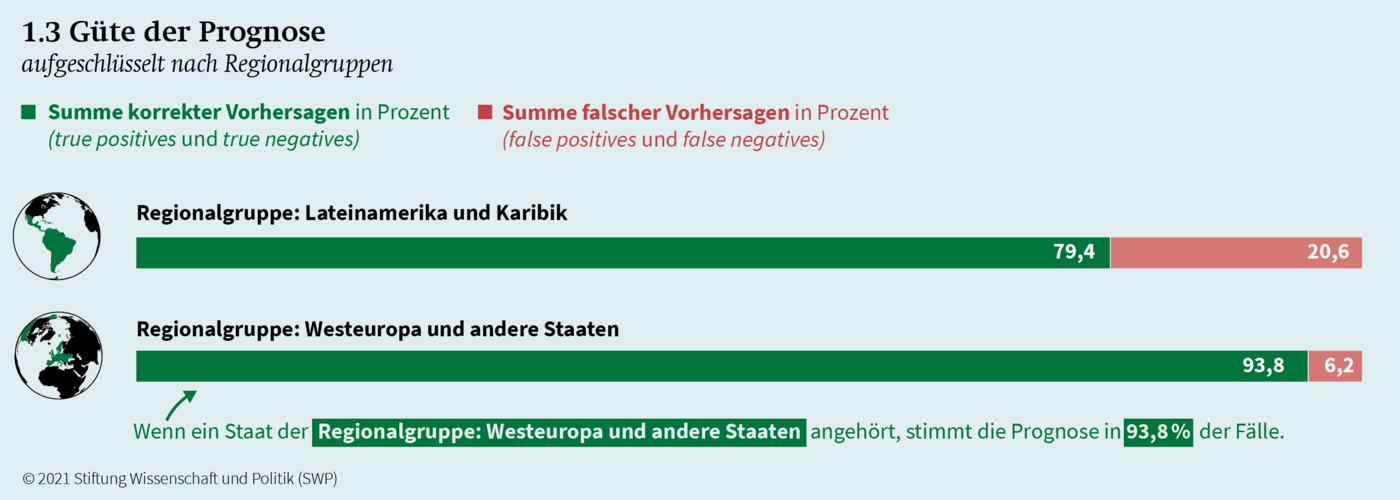

1.3 Güte der Prognose, aufgeschlüsselt nach Regionalgruppen

In Abbildung 1.3 wird deutlich, dass zudem eine große Heterogenität bezüglich der Regionen und Prognosegüte herrscht. In Westeuropa haben verläuft das Abstimmungsverhalten von Staaten nach einem recht stabilen Muster, was die Prognose vereinfacht. In Lateinamerika und der Karibik ist die Prognose wesentlich häufiger falsch.

In der Gesamtschau zeigt sich, dass die Nutzung von machine learning nicht automatisch zu einer guten Prognose führt, sondern dass informierte und nachvollziehbare Entscheidungen bei der Modellspezifikation von großer Wichtigkeit sind. Ein blindes Trainieren anhand verfügbarer Daten mit Blick auf den F1-Score führt nicht unbedingt zu praktisch anwendbaren oder guten Prognosen.