Content Moderation in autoritären Staaten

Wie soziale Medien zu Komplizen autoritärer Herrscher zu werden drohen

SWP-Aktuell 2022/A 39, 13.06.2022, 8 Pagesdoi:10.18449/2022A39

Research AreasTäglich gibt es Berichte darüber, wie private Betreiber sozialer Medien sich problematischen Vorgaben autoritärer Herrscher beugen. Ob in Thailand, Kasachstan oder Russland, immer wieder werden als Teil von Content Moderation (CM) gezielt Inhalte entfernt oder Konten gelöscht, weil Regierungen sich durch Äußerungen in den sozialen Medien kritisiert fühlen. Diesen Einzelfällen liegt ein systemisches Problem von globaler Reichweite zugrunde. Die großen Betreiber sozialer Medien aus den USA bieten ihre Dienste in einer Vielzahl autoritärer Staaten an und erreichen hier Hunderte Millionen Nutzerinnen und Nutzer. Dabei laufen sie Gefahr, zu Komplizen bei der Verletzung von Menschenrechten werden. Um das Verhalten der Unternehmen hinsichtlich dieses Problems überprüfen zu können, sollte sich die deutsche Politik international dafür einsetzen, dass öffentlich einsehbare Human Rights Impact Assessments (HRIAs) verpflichtend vorgegeben werden.

Die weltweite Ausbreitung des Internets ab den 1990er Jahren war von großen Hoffnungen begleitet. In seiner Frühzeit galt das Internet als Heilsbringer der Demokratie, rückte doch das Ideal einer wirklich inklusiven Öffentlichkeit in greifbare Nähe. Die besondere Rolle sozialer Medien zu Beginn des »Arabischen Frühlings« schien dies zu bestätigen. Heute hingegen gelten soziale Medien zunehmend als Bedrohung für die Demokratie. Der »Sturm aufs Kapitol« im Januar 2021 wird vielfach als Beleg für die Gefahren für die Demokratie gedeutet, die von den polarisierten und radikalisierten Öffentlichkeiten der sozialen Medien ausgehen.

Die Folge ist eine umfangreiche politische Debatte um die Grenzen der Meinungsfreiheit im digitalen Raum. Weil alle relevanten sozialen Medien von privaten Unternehmen betrieben werden, geht es dabei auch darum, die Verantwortung öffentlicher wie privater Akteure für Schutz und Gewährleistung von Grund- bzw. Menschenrechten neu zu bestimmen. Der tendenziell euphemistische Begriff der Content Moderation umfasst die Praxis der privaten Plattformbetreiber zur Umsetzung staatlicher Vorgaben ebenso wie eigener Community-Regeln bzw. Allgemeiner Geschäftsbedingungen.

Mit dem jüngst vereinbarten Digital Services Act (DSA) hat die Europäische Union (EU) einen umfassenden, in dieser Form weltweit einzigartigen Vorschlag gemacht, wie solche digitalen Plattformen und Dienste innerhalb der EU reguliert werden sollen. Bei aller berechtigten Sorge um den Erhalt demokratischer Ordnungen droht dabei allerdings aus dem Blick zu geraten, welche Effekte CM in nichtdemokratischen, mehr oder weniger offen autoritären Regimen hat bzw. haben kann. Wie plausibel ist die Hoffnung, soziale Medien könnten demokratische Akteure unter den erschwerten Bedingungen autoritärer Herrschaft stärken, wenn wir denselben sozialen Medien dieses emanzipatorische Potenzial in Öffentlichkeiten mit langer demokratischer Tradition zunehmend absprechen? Wie sollten sich Unternehmen, die aus liberalen Demokratien heraus entstanden sind, verhalten, wenn autoritäre Herrscher die Meinungsfreiheit für ihre Zwecke beschränken wollen? Welche Verantwortung haben hierbei demokratische Regierungen?

Effekte sozialer Medien in autoritären Regimen

Es ist verlockend und doch analytisch unzureichend, den sozialen Medien als Technologie in deterministischer Weise soziale Effekte zuzuschreiben. Welche gesellschaftlichen Auswirkungen Technologien haben, hängt immer davon ab, wer sie unter welchen Umständen und für welche Zwecke nutzt. Nach diesem Verständnis sehr hilfreich sind Überlegungen von Guy Schleffer und Benjamin Miller. In einer explorativen Studie betrachten sie außer dem Regime-Typ auch den Grad der Konsolidierung staatlicher Macht und Handlungsfähigkeit. Für den Kontext autoritärer Staaten lautet die Frage demnach: Wem gelingt es, sich die Macht sozialer Medien zunutze zu machen – der Opposition bzw. der Zivilgesellschaft oder aber der Regierung?

In einem schwachen autoritären Regime, so ihr Argument, können soziale Medien zu dessen Destabilisierung beitragen. Hier ermöglichen sie die Vernetzung und Selbstorganisation zivilgesellschaftlicher Akteure und somit Formen kollektiver Opposition. Schleffer und Miller nennen als Beispiel die Nutzung sozialer Medien als Grundlage für die Proteste in Ägypten 2011. Auch wenn das ägyptische Regime zu der Zeit in vielerlei Hinsicht als gefestigt wahrgenommen wurde, hatte die Regierung nur wenig Möglichkeiten, das Geschehen in den sozialen Medien zu kontrollieren – insbesondere im Vergleich zu traditionellen Medien (vgl. hierzu SWP Research Paper 5/2016). Ein aktuelles Beispiel ist die digitale Vernetzung der Mitglieder der Demokratiebewegung in Hongkong in dem Moment, als der Machtanspruch Pekings in Form eines neuen Sicherheitsgesetzes manifest wurde, vor Ort aber noch nicht gänzlich durchgesetzt war. Beide Fälle verdeutlichen indes auch die Grenzen des Arguments: Bis heute ist empirisch umstritten, welche Bedeutung diese technischen Möglichkeiten in Relation zu anderen Erklärungsansätzen haben. Zudem ist offen, was politisch auf eine von sozialen Medien unterstützte Destabilisierung folgt.

In gefestigten autoritären Staaten hingegen ist nach Schleffer und Miller oftmals zu beobachten, dass die Plattformen zu einem Werkzeug der Regierungen werden, um unliebsame Opposition zu unterdrücken, eigene Narrative und Propaganda zu verbreiten und so ihre eigene Machtposition zu konsolidieren. Insbesondere achten diese Regime auch darauf, das kommunikative Wirken externer Akteure, wie anderer Staaten oder transnationaler Nichtregierungsorganisationen (NGOs), zu kontrollieren. Gefestigte autoritäre Staaten verfügen dabei nicht nur über die administrativen und technischen Kapazitäten, an vielen Stellen selbst in die Kommunikationsflüsse einzugreifen. Sie üben darüber hinaus gezielt Druck auf die privaten Betreiber sozialer Medien aus. Dazu gehört etwa die Drohung, den Zugang zum nationalen Markt zu versperren. Schleffer und Miller führen als Beispiele hierfür China und Russland an, weisen aber auch darauf hin, dass mittlerweile eine Reihe weiterer Staaten versucht, derartige Fähigkeiten zu erlangen – oft durch den Import entsprechender Technologie und Dienste aus China oder Russland.

Eine Analyse von Andrea Kendall-Taylor, Erica Frantz und Joseph Wright auf der Grundlage von Daten zu Massenprotesten von 2000 bis 2017 liefert hierzu weitere, ernüchternde Hinweise: Für autoritäre Regime, die sich die vielfältigen Möglichkeiten digitaler Repression gerade auch mittels sozialer Medien zunutze machen können, geht von Protest- und Demokratiebewegungen ein geringeres Risiko aus, so ein Ergebnis. Viele Regierungen hätten dies erkannt und bemühten sich seit Jahren darum, die entsprechenden technischen Fähigkeiten auszubauen. Dabei böten neue Technologien, beispielsweise Künstliche Intelligenz, autoritären Regimen kostengünstige Möglichkeiten, Opposition sowie eigene Regierungsmitglieder zu überwachen. Häufig führe dann schon allein die Sorge davor, im digitalen Raum überwacht zu werden, zu Angst und Selbstzensur.

Politische Entscheidungen der Unternehmen

Vor diesem Hintergrund müssen sich die Betreiber sozialer Medien damit auseinandersetzen, unter welchen Umständen sie ihre Dienste in autoritären Staaten anbieten – und inwieweit sie bereit sind, sich den Forderungen der jeweiligen Regierungen anzupassen. Dies ist umso wichtiger, als es in autoritären Staaten keine unabhängigen Gerichte gibt, die das Handeln der Regierungen überprüfen und notfalls eingreifen könnten. Die Anbieter sozialer Medien müssen daher selbst entscheiden, welchen Regierungsanfragen sie Folge leisten.

Die Bevölkerungen auch autoritärer Staaten sind für sie zunächst eine attraktive Zielgruppe. Im Bewusstsein um die Skalen- und Netzwerkeffekte sozialer Medien sind deren Betreiber stets bemüht, weiter zu wachsen. Weil die Märkte westlicher Demokratien oftmals schon weitgehend gesättigt sind, geraten für US-Anbieter zunehmend auch nichtwestliche Gesellschaften in den Blick.

Anders als für die Konkurrenz aus China entsteht dabei für die großen Betreiber aus den USA eine konfliktgeladene Spannung zwischen den normativen Vorgaben ihrer Heimatstaaten sowie ihrem Selbstverständnis einerseits und den Begehrlichkeiten autoritärer Regime andererseits. In gewissem Maße sind global operierende Unternehmen seit jeher mit dieser Spannung konfrontiert, etwa wenn es um Fragen von Arbeits- und Umweltschutz geht. Die Besonderheit sozialer Medien liegt darin, dass hier breite Teile der Bevölkerung betroffen sind – und dies in einem Bereich, der sehr direkt Fragen politischer Herrschaft berührt.

Bisher sind die Entscheidungen der Unternehmen im Wesentlichen von ihrer Unternehmenskultur geprägt oder, zugespitzt formuliert, vom politischen Selbstverständnis einzelner Führungspersönlichkeiten. Nicht frei von Ironie ist, dass Konzerne wie Facebook und Google in den USA und Europa auf liberale bis libertäre Rhetorik zurückgreifen, um sich staatlicher Regulierung entgegenzustellen, gleichzeitig aber in vielen Fällen vergleichsweise geräuscharm den Begehren autoritärer Regierungen nachkommen.

Aktuelle Beispiele illustrieren dies:

-

2017 verbannte Snapchat den Nachrichtenanbieter »Al Jazeera« auf Anfrage der Regierung Saudi-Arabiens für Nutzerinnen und Nutzer von seiner »Discover-Seite«, über die Unternehmen redaktionelle Inhalte wie Videos bewerben können.

-

2018 entschied sich Facebooks Führung, einer Aufforderung der türkischen Regierung zu entsprechen, die Facebook-Seite der kurdischen Volksverteidigungseinheiten (YPG) für Facebook-Nutzer und ‑Nutzerinnen in der Türkei zu blocken. Zwischenzeitlich sind interne E‑Mails von Facebook öffentlich geworden, aus denen die Sorge der Firma hervorgeht, dass andernfalls die türkische Regierung den Zugang zu Facebook in Gänze blockieren würde.

-

2020 entschied Mark Zuckerberg persönlich, Facebook solle Anfragen der vietnamesischen Regierung nachkommen, regierungskritische Inhalte zu löschen. Auch hier war andernfalls zu befürchten, den Zugang zum vietnamesischen Markt zu verlieren.

-

2021 folgten Apple und Google einer Aufforderung der russischen Regierung, im Vorfeld der Parlamentswahlen in Russland eine App der Opposition rund um Navalny aus ihren App-Stores zu entfernen. Die App diente regierungskritischen Wählerinnen und Wählern zur Information. In Medienberichten werden interne E-Mails von Google zitiert, wonach für diese Entscheidung die Sicherheit der Mitarbeiter und Mitarbeiterinnen vor Ort ausschlaggebend gewesen sei.

-

Ebenfalls 2021 berichteten mehrere Medien, Apple habe auf Verlangen der chinesischen Regierung eine populäre Koran-App aus dem chinesischen App-Store entfernt. Schon seit längerem gibt es Berichte, dass Apple in China gezielt solche Apps aus dem Angebot nimmt, die Bezüge zum Tiananmen-Massaker oder zur Taiwanfrage enthalten.

Diese Beispiele geben Einblick in die Erwägungen, die den Entscheidungen der Unternehmen zugrunde liegen. Eine nachvollziehbare Sorge gilt den eigenen Beschäftigten in den jeweiligen Ländern, von denen viele aus eben diesen Ländern kommen und damit sehr direkt dem Zugriff der Regierungen ausgesetzt sind.

Immer wieder weisen Vertreter und Vertreterinnen von Betreibern sozialer Medien auch darauf hin, dass die Folgen für die Bevölkerung möglicherweise noch schwerwiegender wären, wenn den Anordnungen einer Regierung nicht entsprochen würde und als Konsequenz die Dienste gar nicht mehr erreichbar wären. Das Problem mit diesem Argument ist allerdings, dass man mit empirischen Annahmen und kontrafaktischen Vermutungen operieren muss, um eine solche Abwägung zu treffen. Weder lässt sich im Vorhinein genau erfassen, wie weit die negativen Folgen von illegitimen Inhaltsbeschränkungen reichen, noch lässt sich genau beziffern, welchen Schaden es bedeuten würde, wenn eine Plattform ihre Dienstleistungen – die als Folge früherer geforderter Inhaltsentfernungen bereits staatlicherseits eingeschränkt sind – überhaupt nicht mehr anbieten könnte. Von außen wird diese Abwägung zudem dadurch schwer nachvollziehbar, dass diese politischen Überlegungen im Ergebnis kaum zu trennen sind vom wirtschaftlichen Interesse am Marktzugang.

In seltenen Fällen entscheiden sich Unternehmen ganz bewusst dafür, ihre Dienste in einem Land nicht mehr anzubieten, um sich dem Zugriff einer autoritären Regierung zu entziehen. Das lange Zeit prominenteste Beispiel hierfür war Googles Entscheidung im Jahr 2010, sich aus Festlandchina zurückzuziehen. Hintergrund waren damals nicht nur stetig zunehmende Zensuranfragen der Regierung, sondern auch ein umfangreicher Hackerangriff, den das Unternehmen der chinesischen Regierung zuschrieb. Wie schwer es sich mit dieser Entscheidung mittlerweile tut, zeigt eine Entwicklung aus dem Jahr 2018: Damals wurde bekannt, dass Google unter neuer Führung Gespräche mit der chinesischen Regierung aufgenommen hatte, um wieder Zugang zum chinesischen Markt zu erlangen. Unter dem Decknamen »Dragonfly« waren sogar bereits Vorarbeiten für eine Adaption der Google-Suchmaschine im Gange, bei der die Zensurvorgaben der chinesischen Regierung integriert werden sollten. Das Bekanntwerden dieser Pläne löste massive Proteste der Google-Mitarbeiter und ‑Mitarbeiterinnen aus, was das Projekt (vorläufig) zum Scheitern brachte.

Eine besondere Situation ist mit dem Angriff Russlands auf die Ukraine im Februar 2022 entstanden. Schon kurz nach Kriegsbeginn wurde innerhalb Russlands der Zugang zu Twitter und Facebook eingeschränkt. Nach Aufforderung durch die EU ergriffen umgekehrt alle großen westlichen Plattformen Maßnahmen, um die Verbreitung von Informationen der russischen Regierung und staatsnaher Medien in der EU zu begrenzen. In einer bis dahin nicht gekannten Form haben Twitter, Google / Alphabet und Meta nur wenige Wochen nach Kriegsbeginn eine Politik der »Demonetarisierung« etabliert (für einen detaillierten Überblick siehe eine Aufbereitung durch Human Rights Watch): Im ersten Schritt nahmen Google / Alphabet und Meta der russischen Regierung und staatsnahen Medien die Möglichkeit, Werbung zu schalten und Einnahmen über die Plattformen zu generieren (Twitter hatte bereits 2019 politische Werbung verboten). Außerdem wurden die Algorithmen so angepasst, dass Inhalte dieser Entitäten als regierungsnah gelabelt und seltener empfohlen wurden. Kurz darauf entschieden Alphabet und Meta, überhaupt keine Werbung mehr in Russland zuzulassen; Twitter ging noch weiter und schloss auch Werbung in der Ukraine aus.

Diese Politik der Demonetarisierung war (und ist) begleitet von der Hoffnung und dem Bemühen, die eigenen Dienste in Russland wenigstens eingeschränkt weiterhin verfügbar zu halten bzw. halten zu können. Das Vorgehen der Plattformen in Russland, genauer gesagt gegenüber russischen Regierungsstellen, ist nicht durch Sanktionen der USA oder der EU notwendig geworden; es geht sogar über diese hinaus (auch wenn die Finanzsanktionen des Westens die wirtschaftlichen Aktivitäten in Russland in jedem Fall erschweren).

Das globale Ausmaß des Problems von CM in autoritären Staaten

Die politischen Entscheidungen von Unternehmen wie zuletzt im Fall des Ukraine-Kriegs werden in der öffentlichen Debatte in der Regel als Einzelfälle wahrgenommen. Die Unternehmen selbst sind hier schon einen Schritt weiter und haben Leitlinien und Verfahrensweisen zum Umgang mit besonderen politischen Ereignissen – von Wahlen bis zu Terroranschlägen – entwickelt. Noch wenig Beachtung finden allerdings die systemischen Herausforderungen, die sich den Unternehmen stellen, wenn sie ihre Dienste in autoritären Staaten anbieten.

Infolge des Wiedererstarkens des Autoritarismus in den letzten rund zwei Jahrzehnten sind Demokratien heute weltweit in der Minderheit. Von den 193 Mitgliedstaaten der Vereinten Nationen (VN) qualifiziert etwa Freedom House für das Jahr 2020 nur 82 als »frei«; auch nach der Klassifikation von Bjørnskov / Rode galten 2020 nur 114 der VN-Staaten als demokratisch – entsprechend lebten rund 3,4 Milliarden Menschen in Autokratien.

Mit Ausnahme stark abgeschotteter Regime werden in vielen autoritären Staaten soziale Medien genutzt. Neben den bekanntesten Foren wie Facebook und Twitter werden in dem vorliegenden Beitrag auch Messengerdienste wie WhatsApp und Instagram dazu gezählt, bei denen Inhalte oftmals in großen Gruppen ausgetauscht werden. Des Weiteren entwickeln sich Gaming-Plattformen wie Discord, Karrierenetzwerke wie LinkedIn oder Code-Repositorien wie Github zunehmend zu Medien, über die sozialer Austausch stattfindet – und sehen sich so mit Forderungen nach CM konfrontiert. Nicht zuletzt vollzieht sich CM auf der Ebene von Infrastrukturen, wenn beispielsweise App-Stores den Vertrieb bestimmter Programme untersagen oder Hosting-Anbieter die Nutzung ihrer Server für bestimmte Dienste oder Domains verbieten.

Nach anhaltendem öffentlichem Druck geben einige der größten Betreiber sozialer Medien seit einigen Jahren Transparenzberichte heraus, die auch Hinweise dazu liefern, welche Anfragen zur Entfernung von Inhalten sie von Regierungen erhalten. Die Analyse dieser Daten ist nicht einfach, weil die Unternehmen ihre Auskünfte unterschiedlich strukturieren. Da sie etwa unterschiedliche Kriterien für die Erfassung von Anfragen zugrunde legen und bei Twitter und YouTube nicht immer klar ist, wie viele dieser Anfragen tatsächlich umgesetzt wurden, ist der Vergleich über die Dienste hinweg nur bedingt möglich.

Bei Facebook und Twitter ist nicht genau ersichtlich, welche der Anfragen von Regierungen, Gerichten oder weiteren Entitäten in dem jeweiligen Staat kommen. Zudem lässt sich nur eingeschränkt nachvollziehen, wie Regierungen es begründen, wenn sie die Entfernung von Inhalten fordern. Neben einigen eher anekdotischen Hinweisen sind hier die Berichte von YouTube am aussagekräftigsten: Auffällig ist, dass autoritäre Staaten sich bei ihren Anfragen sehr viel häufiger auf die Kategorien »nationale Sicherheit« und »Kritik an der Regierung« beziehen als demokratische Staaten; die Kategorien »Copyright« und »Verleumdung« spielen hingegen bei den Anfragen demokratischer Regierungen eine größere Rolle.

|

Tatsächlich erfolgte Inhaltsbeschränkungen (Facebook) und gestellte Anfragen zur Entfernung von Inhalten (Twitter, YouTube), 2014–2020 |

||||

|

Regimetyp autoritär |

Regimetyp |

|

||

|

Facebook |

Staatlichkeit niedrig Staatlichkeit hoch |

32.992 (11,0%) 700 (0,2%) |

178.292 (59,2%) 89.096 (29,6%) |

211.284 (70,2%) 89.796 (29,8%) |

|

Summe |

33.692 (11,2%) |

267.388 (88,8%) |

301.080 (100,0%) |

|

|

Twitter |

Staatlichkeit niedrig Staatlichkeit hoch |

83.209 (45,9%) 1.163 (0,6%) |

20.880 (11,5%) 75.862 (41,9%) |

104.089 (57,5%) 77.025 (42,5%) |

|

Summe |

84.372 (46,6%) |

96.742 (53,4%) |

181.114 (100,0%) |

|

|

YouTube |

Staatlichkeit niedrig Staatlichkeit hoch |

82.148 (84,6%) 73 (0,1%) |

10.235 (10,5%) 4.600 (4,7%) |

92.383 (95,2%) 4.673 (4,8%) |

|

Summe |

82.221 (84,7%) |

14.835 (15,3%) |

97.056 (100,0%) |

|

|

Quellen: Facebook, Content Restrictions Based on Local Law; Google (YouTube), Government Requests to Remove Content; Twitter, Removal Requests. Aggregierte Werte, Prozentzahlen gerundet. Daten für den Regimetyp entnommen aus: Christian Bjørnskov / Martin Rode, Regime Types and Regime Change: A New Dataset, v.3.2. Indikator für Staatlichkeit basierend auf der Variable »z_statehood« in Eric Stollenwerk / Jan Opper, The Governance and Limited Statehood Dataset, Berlin: Freie Universität Berlin, SFB 700, 2017. Weitere Informationen zur Datenanalyse können unter https://bit.ly/SWP22AP02FG08 abgerufen werden. |

||||

Ausgehend vom bisherigen Stand der Debatte nimmt die Tabelle in den Blick, wie sich das Verhalten autoritärer und demokratischer Regime bezüglich solcher Anfragen unterscheidet. Als weitere Differenzierung wird der Grad an Staatlichkeit ergänzt.

Die Ergebnisse dieser quantitativen Auswertung auf globaler Ebene sind in mancherlei Hinsicht im besten Sinne überraschend: Zunächst fällt auf, dass ein erheblicher Teil der jeweiligen Anfragen aus demokratischen Staaten kommt, besonders im Falle von Facebook. Dies muss kein Problem sein, wenn man davon ausgeht, dass hier das Handeln der Regierungen rechtsstaatlich eingehegt ist. Die schiere Menge an Anfragen gibt aber dennoch zu denken; vertiefende Analysen hierzu wären sicherlich sinnvoll.

Interessant ist, dass unter den autoritären Staaten diejenigen hervorstechen, die über ein geringes Niveau an Staatlichkeit verfügen. Dies steht im Widerspruch zu den bisherigen Studien zum Thema, die vor allem auf einzelne Staaten fokussieren. Eine Erklärung hierfür könnte sein, dass Staaten, die generell durch einen niedrigen Grad an Staatlichkeit geprägt sind, gezielt Kapazitäten zur Kontrolle sozialer Medien aufbauen. Eine weitere, dass autoritäre Staaten mit einem hohen Grad an Staatlichkeit andere Vorgehensweisen als CM wählen, sie etwa Dienste US-amerikanischer Anbieter vollständig blockieren.

In jedem Fall zeigt die quantitative Analyse am Beispiel der drei großen US-Anbieter, dass diese mit einer substanziellen Anzahl von Anfragen autoritärer Regime konfrontiert sind. Die politische Herausforderung, mit diesen Anfragen umzugehen, ist mithin keinesfalls auf Einzelfälle beschränkt, sondern eine systemische.

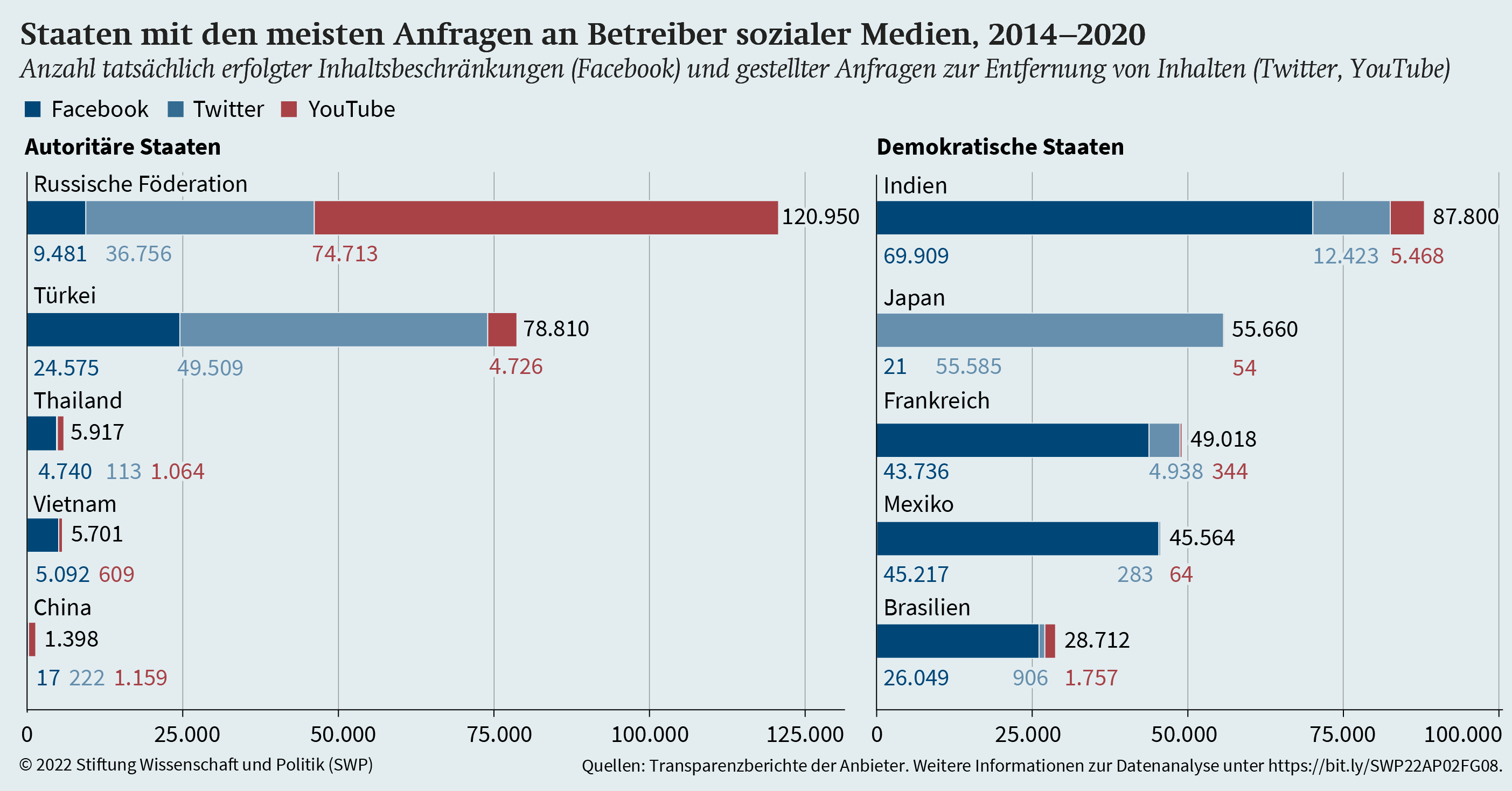

In einem weiteren Schritt wurden für den vorliegenden Beitrag die globalen Daten daraufhin untersucht, welche Staaten besonders herausstechen. Die Abbildung listet jeweils die fünf autoritären und die fünf demokratischen Länder, aus denen von 2014 bis 2020 die meisten Anfragen zur Entfernung von Inhalten kamen. Auf diese zehn Staaten entfallen 82,4% aller Anfragen bzw. erfolgten Beschränkungen des genannten Zeitraums, davon 36,6% auf die fünf autoritären, 45,8% auf die fünf demokratischen Staaten.

|

|

|

Quellen: Facebook, Content Restrictions Based on Local Law; Google (YouTube), Government Requests to Remove Content; Twitter, Removal Requests. Aggregierte Werte, Prozentzahlen gerundet. Daten für den Regimetyp entnommen aus: Christian Bjørnskov / Martin Rode, Regime Types and Regime Change: A New Dataset, v.3.2. Weitere Informationen zur Datenanalyse können unter https://bit.ly/SWP22AP02FG08 abgerufen werden. |

Diese Darstellung macht sichtbar, in welchen Ländern diese Fragen aktuell von hoher Brisanz sind. Dabei fallen unter anderem Indien und Mexiko auf. Sie werden in der Wissenschaft bisher als Demokratien klassifiziert; in beiden Ländern geraten demokratische Institutionen aber zunehmend unter Druck.

Internationaler Handlungsbedarf

Der Ruggie Report von 2008 beschreibt als Mindestanforderung an Unternehmen, dass sie vermeiden sollen, selbst zur Verletzung von Menschenrechten beizutragen. Dieser Bericht ist als solcher nicht bindend, formuliert aber einen plausiblen normativen Standard (dem man allenfalls vorhalten kann, er sei zu wenig ambitioniert). Auch der Europarat hat sich in einer Empfehlung von 2018 zur Verantwortung von »internet intermediaries« dieses Verständnis von den menschenrechtlichen Pflichten der Unternehmen im digitalen Raum zu eigen gemacht.

Gemessen an diesem Standard stellt es ein Fehlverhalten dar, wenn die Betreiber sozialer Medien sich Anforderungen von autoritären Regimen beugen, die erkennbar im Widerspruch zu den international anerkannten Menschenrechten stehen. Ein solches Verhalten wird nicht dadurch wettgemacht, dass die wirtschaftlichen Aktivitäten der Betreiber auch positive Effekte haben können. Der Ruggie Report enthält hierzu klare Leitlinien: »Business enterprises may undertake other commitments or activities to support and promote human rights, which may contribute to the enjoyment of rights. But this does not offset a failure to respect human rights throughout their operations.«

Anders ausgedrückt: Im Falle offenkundiger Menschenrechtsverletzungen sind die Unternehmen keineswegs mit einer komplexen Abwägung konfrontiert. Vielmehr ist im Grunde klar, dass sie keinen Anforderungen Folge leisten dürfen, die im Widerspruch zu den Menschenrechten stehen. Ansonsten droht ihnen, zu Komplizen autoritärer Herrscher zu werden. Sie sollten sich diesen Anforderungen widersetzen und notfalls in Kauf nehmen, dafür den Zugang zu den entsprechenden Märkten zu verlieren.

Klärungsbedarf kann sich allerdings dann ergeben, wenn nicht eindeutig ersichtlich ist, ob eine Regierungsanfrage im Widerspruch zu den Menschenrechten steht. Wie man an einigen der genannten Beispiele ablesen kann, werden derlei Fälle vor allem als Einzelfallentscheidungen verstanden, die die jeweiligen Unternehmensleitungen zu treffen haben. Im Lichte des systemischen Charakters dieses Problems scheint es jedoch notwendig, einen systematischen Umgang mit diesen Fragen zu finden.

Viele westliche Betreiber sozialer Medien beteiligen sich bereits an Bemühungen, für diese Fragen normative Standards zu entwickeln. Beispiele hierfür sind die Ausarbeitung der Santa Clara Principles oder die kontinuierliche Kooperation im Rahmen der Global Network Initiative (GNI).

Letztlich aber sind es die jeweiligen Unternehmen bzw. deren Leitungen, die die konkreten Entscheidungen treffen (müssen). Das Problem dabei ist, dass die Unternehmen alleine nicht über die Legitimität verfügen, derart politisch folgenreiche Entscheidungen zu fällen. Im Prinzip wäre genau dies die Aufgabe dafür geeigneter öffentlicher Institutionen. Auf globaler Ebene aber gibt es keine derartige Institution. Da die großen westlichen Unternehmen für soziale Medien zurzeit allesamt aus den USA kommen, könnten entsprechende Vorgaben von der US-Regierung erlassen werden, gewissermaßen in Anlehnung an die Kontrolle von Dual-Use-Gütern. Doch auch hiermit ist derzeit nicht zu rechnen.

Einen wichtigen Zwischenschritt hin zu einer politischen Lösung könnten indes striktere Vorgaben für regelmäßige Human Rights Impact Assessments darstellen (vgl. hierzu die Empfehlungen des Forschungsprojektes Ranking Digital Rights). Ziel solcher Analysen wäre eine systematischere Auseinandersetzung mit dem Handeln der Betreiber sozialer Medien in autoritären Kontexten. Nicht zuletzt könnte eine verpflichtende Vorgabe zu derartigen HRIAs auch den demokratischen Akteuren in den betroffenen Ländern helfen: Wenn diese Berichte öffentlich zugänglich gemacht würden, könnten die Akteure vor Ort sie nutzen, um das Handeln ihrer Regierungen zu hinterfragen.

Legt man noch einmal die obige Datenanalyse zugrunde, scheint es sinnvoll, insbesondere jene autoritären Staaten und gefährdeten Demokratien in den Blick zu nehmen, aus denen die US-Unternehmen die meisten Regierungsanfragen erhalten (s. Abbildung). Zumindest ex post wäre es so möglich, öffentlich eine Debatte darüber zu führen, ob die Entscheidungen der Unternehmen rechtfertigbar waren. Deutschland und die EU könnten international und vor allem im bilateralen Verhältnis zur US-Regierung auf eine solche Erweiterung der Transparenzanforderungen drängen.

Dabei reicht Transparenz alleine nicht aus. Stattdessen ist es unumgänglich, dass den HRIAs auch Taten folgen. So können zum Beispiel, basierend auf den Menschenrechtsanalysen, frühzeitig Krisenprotokolle für Länder entwickelt werden, die zunehmend autoritär werden. Anstelle von kurzfristigem Aktivismus der Plattformen, nachdem eine Krise schon eingetreten ist, könnten HRIAs wie eine Art digitales Frühwarnsystem funktionieren – es ließe sich feststellen, wenn in einem Land die Regierungsanfragen zur Entfernung von Inhalten zunehmen. Eine solche politische Dynamik könnte auf diese Weise rechtzeitig wahrgenommen und entsprechende Gegenmaßnahmen eingeleitet werden, bevor sich eine Krise zuspitzt.

Paula Köhler ist Forschungsassistentin der Forschungsgruppe Sicherheitspolitik. Dr. Daniel Voelsen ist Leiter der Forschungsgruppe Globale Fragen.

© Stiftung Wissenschaft und Politik, 2022

Alle Rechte vorbehalten

Das Aktuell gibt die Auffassung des Autors und der Autorin wieder.

SWP-Aktuells werden intern einem Begutachtungsverfahren, einem Faktencheck und einem Lektorat unterzogen. Weitere Informationen zur Qualitätssicherung der SWP finden Sie auf der SWP-Website unter https://www. swp-berlin.org/ueber-uns/ qualitaetssicherung/

SWP

Stiftung Wissenschaft und Politik

Deutsches Institut für Internationale Politik und Sicherheit

Ludwigkirchplatz 3–4

10719 Berlin

Telefon +49 30 880 07-0

Fax +49 30 880 07-100

www.swp-berlin.org

swp@swp-berlin.org

ISSN (Print) 1611-6364

ISSN (Online) 2747-5018

doi: 10.18449/2022A39